Suchmaschinenoptimierung ist fast so alt wie das kommerzielle Internet – vor mehr als 25 Jahren habe ich zum ersten Mal darüber geschrieben – damals in der Internet Professionell. Das Grundprinzip ist gleichgeblieben: Ein Nutzer gibt bei einer Suchmaschine einen Suchstring ein, schickt diesen ab und bekommt als Resultat eine Ergebnisliste. Im Gegenzug gibt es Betreiber…… SEO & KI – Theorie und Praxis weiterlesen

Autor: Andreas Werner

KI-Marktentwicklung und der Open AI App Store

Ein neuer Meilenstein: Der Open AI App Store An der Schwelle zum neuen Jahr plante ich, über die aktuelle Marktentwicklung im Bereich der Künstlichen Intelligenz zu schreiben, doch Zeitmangel hinderte mich daran. Jetzt hat sich die Situation dramatisch gewandelt mit der Einführung des Open AI App Stores. Viele haben diese Entwicklung übersehen, obwohl sie schon…… KI-Marktentwicklung und der Open AI App Store weiterlesen

KI und wirtschaftliche Verwerfungen – SEO, Medieneinnahmen & Jobs

Eigentlich scheue ich mich davor, einen Beitrag zur aktuelle KI-Diskussion zu schreiben. Allerdings reagieren viele Schreiber, die aktuell Google & Microsoft überstürztes Verhalten vorwerfen, nicht viel anders in ihren eigenen Texten. Die eigene Situation wird an-analysiert – nicht bis zum Ende. Beschäftigt sich ein Mensch mit SEO, überlegt dieser zunächst, was er (oder sie) mit…… KI und wirtschaftliche Verwerfungen – SEO, Medieneinnahmen & Jobs weiterlesen

Digital Analytics für Hersteller erweitern – die produktzentrische Perspektive als Ergänzung

Das Nutzerzentrische Bild, das Google uns mit seinen Analytics-Lösungen präsentiert, ist eben nur die eine Seite der Münze. Die andere Seite sind Produkte und Marken.

Digital Analytics vs. Business Analytics

Digital Analytics sollte integrierter Teil der Business Analytics sein. Dies ist meist noch nicht wirklich so und das ist mehr als nur schade. Es ist fatal. Beide Welten sollten sich aufeinander zubewegen und gemeinsam an Optimierungsstrategien arbeiten.

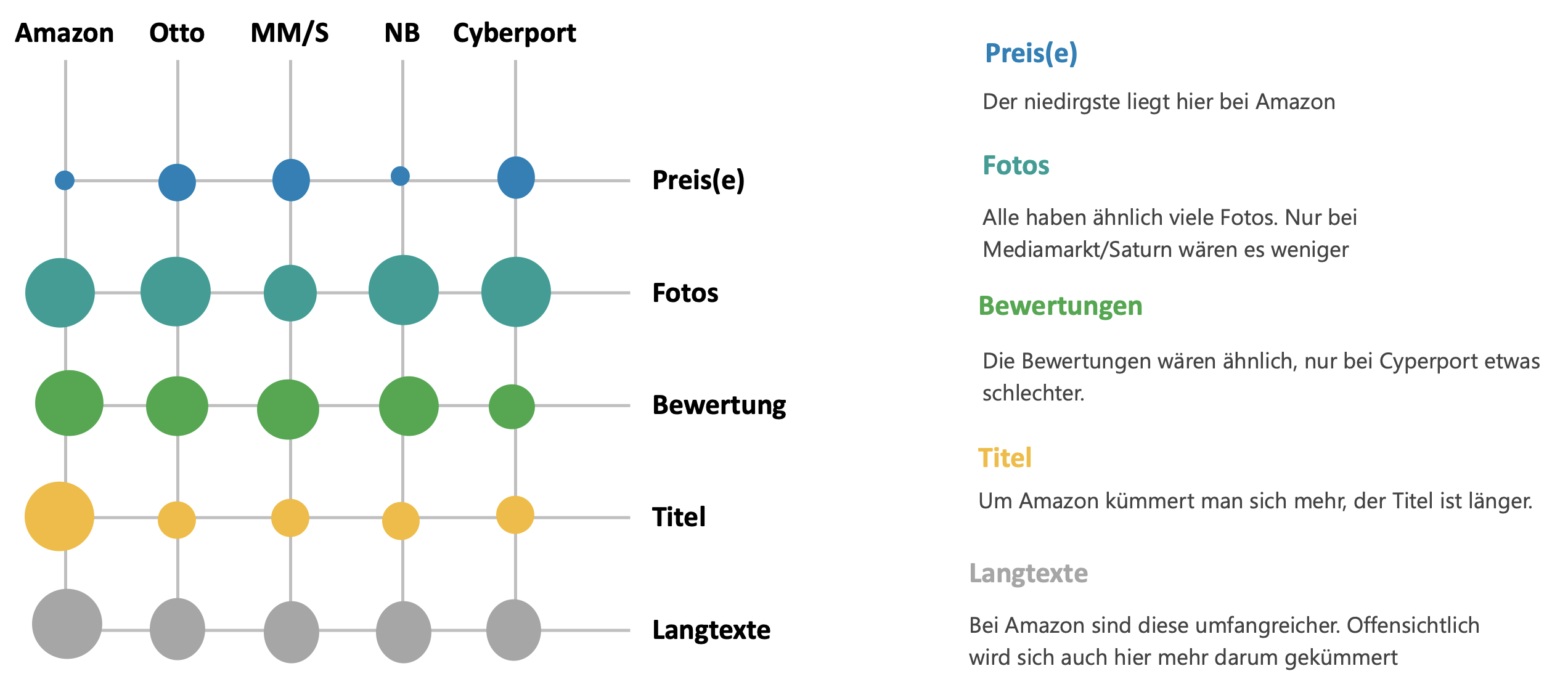

Product Data Crawling – so besorgen Sie sich strukturiert Produktdaten aus Online Shops

Für die Erfolgreiche Arbeit auf Online-Marktplätzen und mit Online-Händlern werden tiefgehende Informationen zu Preisen und Darstellung der Produkten auf den Plattformen benötigt – nicht nur zu Amazon. Hier erkläre ich, wie diese Daten per Product Data Crawling generierbar sind.

Einsatz von PIMs in betrieblichen Prozessen

Ganz grundsätzlich im Kern schafft man mit einem PIM einen Single Point of Truth für die Verteilung von Produktstammdaten. Es wird ein Topf geschaffen, in dem alles – wirklich alles – drin und/oder damit verbunden ist. Weitere Silos sind nicht erlaubt. Das heißt jedoch im Gegenzug nicht, dass das PIM für alle enthaltenen Daten das führende System ist oder sein muss.

Der Cookie ist tot – es lebe Retail Media!

Marktplätze können von der Wirkungslosigkeit der Cookies enorm profitieren – wenn sie ihr Media-Geschäft entsprechend aufstellen

Aus meiner Sicht klar nach oben mit Retail Media. Das hat verschiedene Gründe. Der wichtigste erscheint mir die heftige Entwicklung bei Amazon zu sein. Dann steigen immer mehr Marktplätze in dieses durchaus attraktive Geschäft mit Retail Media ein – sozusagen der Ersatz für den guten alten Werbekostenzuschuss (WKZ). Zuletzt ist es noch so, dass innerhalb der Plattformen durch den meist automatisierten Login-Vorgang genaue Targeting-Optionen bestehen, die durch den Cookie Exodus zum Teil verschwunden sind.

Nur noch kontextbasierte Werbung in Europa?

Was bewirkt Mikro-Targeting?

Ein gesunder Mittelweg, ohne bei den Kund:innen zu aufdringlich und ausspähend zu werden, ist aus meiner Sicht langfristig am erfolgversprechendsten. Ohnehin ist der alleinige Einsatz von Performance Marketing und Mikro-Tarketing nicht ausreichend,

Reden Sie ihren Kunden den Visitor aus! Besucher sind nicht valide messbar und taugen als KPI nicht

Immer wieder lese ich über Visitor-Zahlen, dabei sind diese kaum bestimmbar – und wenn, dann nur unter eng eingegrenzten Bedingungen. Schon seit über zehn Jahren versuche ich, die Kennzahl – KPI – bei meinen Jobs zu vermeiden. Sie taugt einfach nicht.