Irgendwas mit Daten

KI, Marken, Analytics, Mediaplanung, DAM, PIM etc.

Ich mache etwas mit Daten

KI, Marken, Analytics, Mediaplanung, DAM, PIM etc.

Was Social Media ist, brauche ich an dieser Stelle nicht zu erläutern. Facebook, Instagram, TikTok, YouTube nehmen einen großen Raum in unserem Leben ein – mal mehr und mal weniger. LinkedIn zielt eher auf den professionellen Bereich ab – dafür werden auch Produkte benötigt. Vor mehr als 10 Jahren als ich mein Buch Social Media – Analytics und Monitoring geschrieben habe, stand dieser Teilbereich des Online Marketing noch in den Kinderschuhen. Es wurde viel versucht, ausprobiert. Das ist bei neuen Medien immer so – die Funktionsweisen für das Marketing müssen erkundet werden. Gerade die Möglichkeit zum direkten Feedback stellte viele weiterlesen…

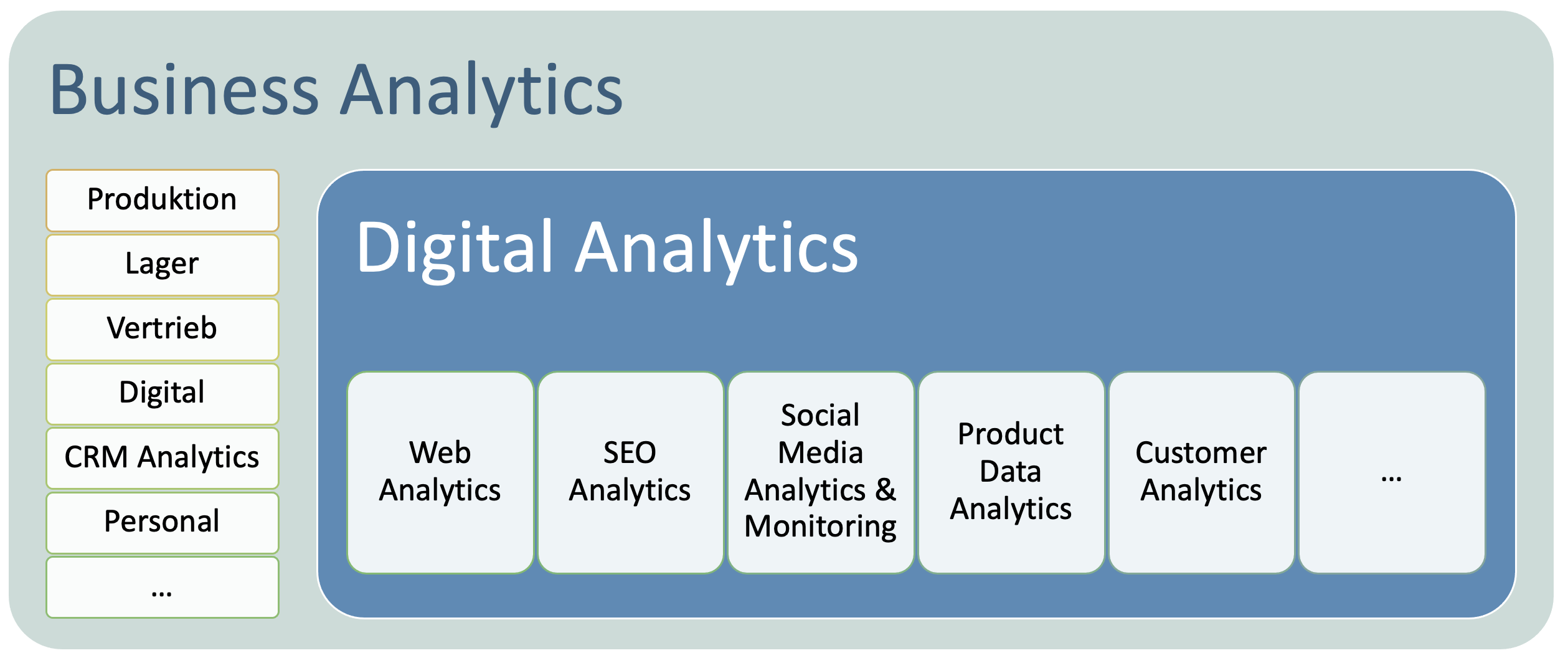

Digital Analytics sollte integrierter Teil der Business Analytics sein. Dies ist meist noch nicht wirklich so und das ist mehr als nur schade. Es ist fatal. Beide Welten sollten sich aufeinander zubewegen und gemeinsam an Optimierungsstrategien arbeiten. weiterlesen…

In der aktuellen t3n (Ausgabe 42) ist ein Beitrag über Analytics-Tools für Start-ups bzw. kleinere Unternehmen. Darin werden einige Klassen von Werkzeugen besprochen. Grundsätzlich ist das nicht schlecht. Allerdings wirkt der Artikel schon so, als ob viele Fragestellungen nur mit diesen Tools zu lösen seien. Anschließend werden die Daten aus jeglicher Quelle Dashbord-Lösung gepackt und alles ist gut. Hierzu gibt es einiges zu sagen. Ich erläutere deshalb hier rudimentär welche Analytics-Daten zur Steuerung eines Web-Projekts notwendig sind. Analytics-Speziallösungen müssen administriert und gelernt werden Vor allem wird die Mächtigkeit von Google Analytics als Werkzeug unterschätzt. Mit Custom Reports und Event-Tagging lässt sich vieles weiterlesen…

Pinterest-Analytics Tools hab ich schon einige beschrieben. Die Tailwind App ist mittlerweile ziemlich wichtig geworden. Sie hat 9.000 Kunden. Das ist nicht zu unrecht so. Mir gefällt das Werkzeug ausgesprochen gut. Es ist für alle alle Unternehmensgrößen einsetzbar und eine richtig gute Hilfe wenn man den eigenen Erfolg auf Pinterest monitoren und Potenziale zu Optimierung finden möchte. Ich kann den Test des Werkzeugs nur empfehlen. Immerhin hat das Unternehmen jetzt 15 Mitarbeiter. Das garantiert aus meiner Sicht den stabilen Bestand des Werkzeugs. Das Tailwind App Dashboard Der gute Eindruck beginnt schon mit dem Dashboard. Es ist aufgebaut wie das bei einem weiterlesen…

Es ist nicht meine Art, fremden Content auf meinem Blog zu platzieren. Hier halte ich es ausnahmsweise für angebracht. Goldbach Interactive hat sich wieder die Arbeit gemacht und superviele Monitoring Tools angeschaut. Auch wenn ich zu einigen Ergebnissen meine eigene Meinung habe und für diskussionswürdig halte, sollte man sich schon anschauen was Goldbach so gemacht hat. Mit dem Klick auf die Infografik gelangt man zu Goldbach. lala

Pinterest ist ein großer Wurf. Das scheint sicher. Hier sind sich die Forscher von ComScore und compete.com einig. Auch im Februar legte der Foto-Bookmark-Dienst wieder ausgesprochen kräftig zu – beinahe 50 Prozent. Dann scheint es auch noch so zu sein, dass Pinterest mehr sehr viel Referral-Traffic liefert als andere Social Media Plattformen. Dies ist Grund genug zu schauen, wie man das Phänomen aus Sicht der Social Media Analytics und des Monitoring angehen sollte, um die Leistung möglichst realistisch zu bewerten und einzuordnen. Erste Dienste, die ein entsprechendes Dashboard entwickelt haben, gibt es bereits – Pinerly & PinReach. Allerdings ist die Datentiefe noch weiterlesen…

„Social Media Monitoring“ wird derzeit heftig diskutiert und scheint zudem ein hart umkämpfter Markt zu sein. Ein Indikator dafür ist die Anzahl der Keyword-Anzeigen, die bei Google für die Phrase aktiv sind. Die Seite ist voll! Gleichzeitig heißt das aber auch, dass es viele Anbieter gibt und der Aufwand zur Auswahl der geeigneten Software bzw. des geeigneten Produkts hoch ist. Wenn Sie sich bereits ein wenig im deutschsprachigen Web umgeschaut haben, werden Sie schon einige ähnliche Beiträge gefunden haben. Stefanie Aßmann hat sich beispielsweise in ihrer Masterarbeit mit dem Thema beschäftigt, betreibt ein Blog dazu und steuert dankenswerterweise auch noch weiterlesen…