Irgendwas mit Daten

KI, Marken, Analytics, Mediaplanung, DAM, PIM etc.

Ich mache etwas mit Daten

KI, Marken, Analytics, Mediaplanung, DAM, PIM etc.

Kennen Sie das Riepl’sche Gesetz? Nein? Es besagt, dass „alte“ Medien nie vollständig durch „neue“ Medien verdrängt werden. Mittlerweile – die Kernaussage ist mehr als 100 Jahre alt – könnte man den Begriff der Verdrängung auch durch Transformation ergänzen. Ein Beispiel: Die gedruckte Zeitung wird nie vollständig auf Ausgabemedien wie Mobiltelefone oder Tablets transformiert. Um es deutlicher zu sagen: Erst wenn ein vollständiges funktionales Äquivalent vorhanden ist, wird dies passieren. Aber darum geht es mir in diesem Beitrag nicht im Kern. Der Kampf der klassischen Medien Derzeit kämpfen periodische Druckmedien, Hörfunk und Fernsehen gegen ihren Bedeutungsverlust im Werbemarkt. Klar ist, weiterlesen…

Ein neuer Meilenstein: Der Open AI App Store An der Schwelle zum neuen Jahr plante ich, über die aktuelle Marktentwicklung im Bereich der Künstlichen Intelligenz zu schreiben, doch Zeitmangel hinderte mich daran. Jetzt hat sich die Situation dramatisch gewandelt mit der Einführung des Open AI App Stores. Viele haben diese Entwicklung übersehen, obwohl sie schon länger als Teil des Bezahlaccounts von Chat GPT existiert. Der Store beinhaltete bisher ausschließlich von Open AI entwickelte Apps, die auf dem Datenmodell von Chat GPT und DALL-E basieren und kostenlos nutzbar waren. Creative Writing Coach: Ein persönlicher Favorit Ein Highlight für mich ist der weiterlesen…

Eigentlich scheue ich mich davor, einen Beitrag zur aktuelle KI-Diskussion zu schreiben. Allerdings reagieren viele Schreiber, die aktuell Google & Microsoft überstürztes Verhalten vorwerfen, nicht viel anders in ihren eigenen Texten. Die eigene Situation wird an-analysiert – nicht bis zum Ende. Beschäftigt sich ein Mensch mit SEO, überlegt dieser zunächst, was er (oder sie) mit dem Tool machen kann – oder ob es alternativ den Job kostet. Hilfreich wäre es, zunächst nach Analogien zu suchen. Davon gibt es in der Entwicklung der Computertechnik der vergangenen 50 Jahre recht viele – sogar die bald 30 Jahre Entwicklung des kommerziellen Internets lassen weiterlesen…

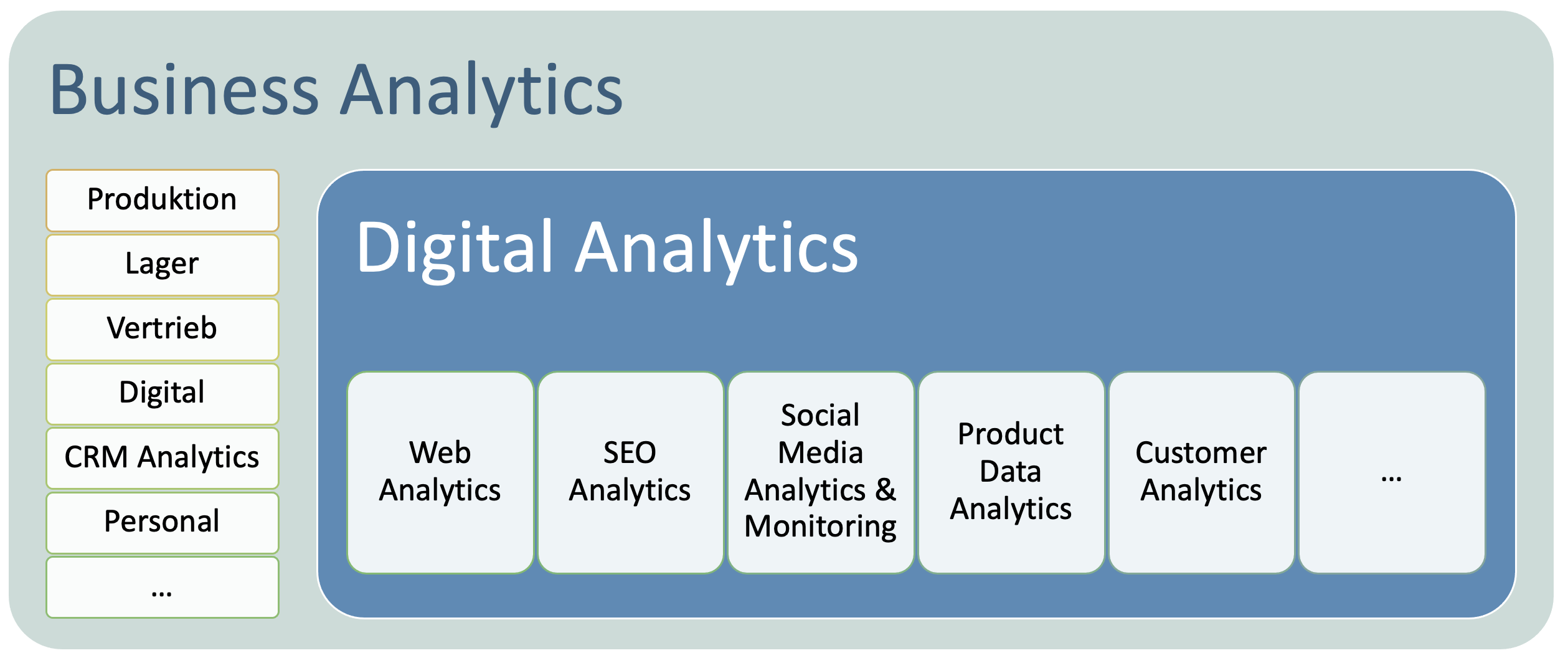

Digital Analytics sollte integrierter Teil der Business Analytics sein. Dies ist meist noch nicht wirklich so und das ist mehr als nur schade. Es ist fatal. Beide Welten sollten sich aufeinander zubewegen und gemeinsam an Optimierungsstrategien arbeiten. weiterlesen…

Ganz grundsätzlich im Kern schafft man mit einem PIM einen Single Point of Truth für die Verteilung von Produktstammdaten. Es wird ein Topf geschaffen, in dem alles – wirklich alles – drin und/oder damit verbunden ist. Weitere Silos sind nicht erlaubt. Das heißt jedoch im Gegenzug nicht, dass das PIM für alle enthaltenen Daten das führende System ist oder sein muss. weiterlesen…

Aus meiner Sicht klar nach oben mit Retail Media. Das hat verschiedene Gründe. Der wichtigste erscheint mir die heftige Entwicklung bei Amazon zu sein. Dann steigen immer mehr Marktplätze in dieses durchaus attraktive Geschäft mit Retail Media ein – sozusagen der Ersatz für den guten alten Werbekostenzuschuss (WKZ). Zuletzt ist es noch so, dass innerhalb der Plattformen durch den meist automatisierten Login-Vorgang genaue Targeting-Optionen bestehen, die durch den Cookie Exodus zum Teil verschwunden sind. weiterlesen…

Immer wieder lese ich über Visitor-Zahlen, dabei sind diese kaum bestimmbar – und wenn, dann nur unter eng eingegrenzten Bedingungen. Schon seit über zehn Jahren versuche ich, die Kennzahl – KPI – bei meinen Jobs zu vermeiden. Sie taugt einfach nicht. weiterlesen…

Man kann erfreulicherweise feststellen, dass die Zahl der Neuinfektionen in den sieben Tagen vom 15.3. bis zum 21.3.2020 mit 361 erheblich höher lag als vom 22.3. bis zum 28.3.2020. Im jüngsten Zeitraum kamen nur 308 neue festgestellte Infektionen hinzu, es handelt sich also um einen Rückgang um rund 15 Prozent. weiterlesen…

Eigentlich ist das hier kein politisches Blog. Aber die Entscheidung der Bundesregierung, die Ticketsteuer resp. Luftverkehrabgabe nur marginal zu erhöhen finde ich einfach handwerklich superschlecht oder von falschen Zielen getrieben. Da wurde wohl schnell etwas total wirkungsloses zu einer ohnehin steuerungslosen Abgabe hinzugefügt, damit etwas gemacht wurde. Das ist einfach nur ärgerlich! Zugegeben, mein Ökonomiestudium in Mannheim liegt schon einige Jahre zurück. Und das was da gemacht wurde widerspricht so ziemlich allem, was ich gelernt habe. Die Ticketsteuer ist eine wirkungslose Mengensteuer Also – in Deutschland gibt es bereits seit 1. Januar 2011 eine Luftverkehrabgabe oder Ticketsteuer. Gebracht hat diese weiterlesen…

2019 feiern wir das 25. Jahr Suchmaschinenoptimierung. SEO war über all die Jahre ein Rennen zwischen Optimieren, Manipulatoren und Suchmaschinen. Suchmaschinen suchten immer nach schwer bzw. aufwändig zu manipulierenden Validatoren als Ranking-Faktoren. Googles Page Rank – grob gesagt, die Links auf eine Seite als Relevanz-Kriterium – ist nun auch schon über 20 Jahre alt. Jetzt kommen die Bilder also SEO-Kriterium dran. So banal, wie das zuletzt in einem t3n-Artikel beschrieben wurde, ist es aber leider nicht. Google kann nämlich erheblich mehr als einfach nur einen Dateinamen auslesen, den ALT-Tag analysieren, den Kontext beurteilen sowie Dateiformate oder Bildauflösungen beurteilen. Bilder als weiterlesen…