Irgendwas mit Daten

KI, Marken, Analytics, Mediaplanung, DAM, PIM etc.

Ich mache etwas mit Daten

KI, Marken, Analytics, Mediaplanung, DAM, PIM etc.

Das Nutzerzentrische Bild, das Google uns mit seinen Analytics-Lösungen präsentiert, ist eben nur die eine Seite der Münze. Die andere Seite sind Produkte und Marken. weiterlesen…

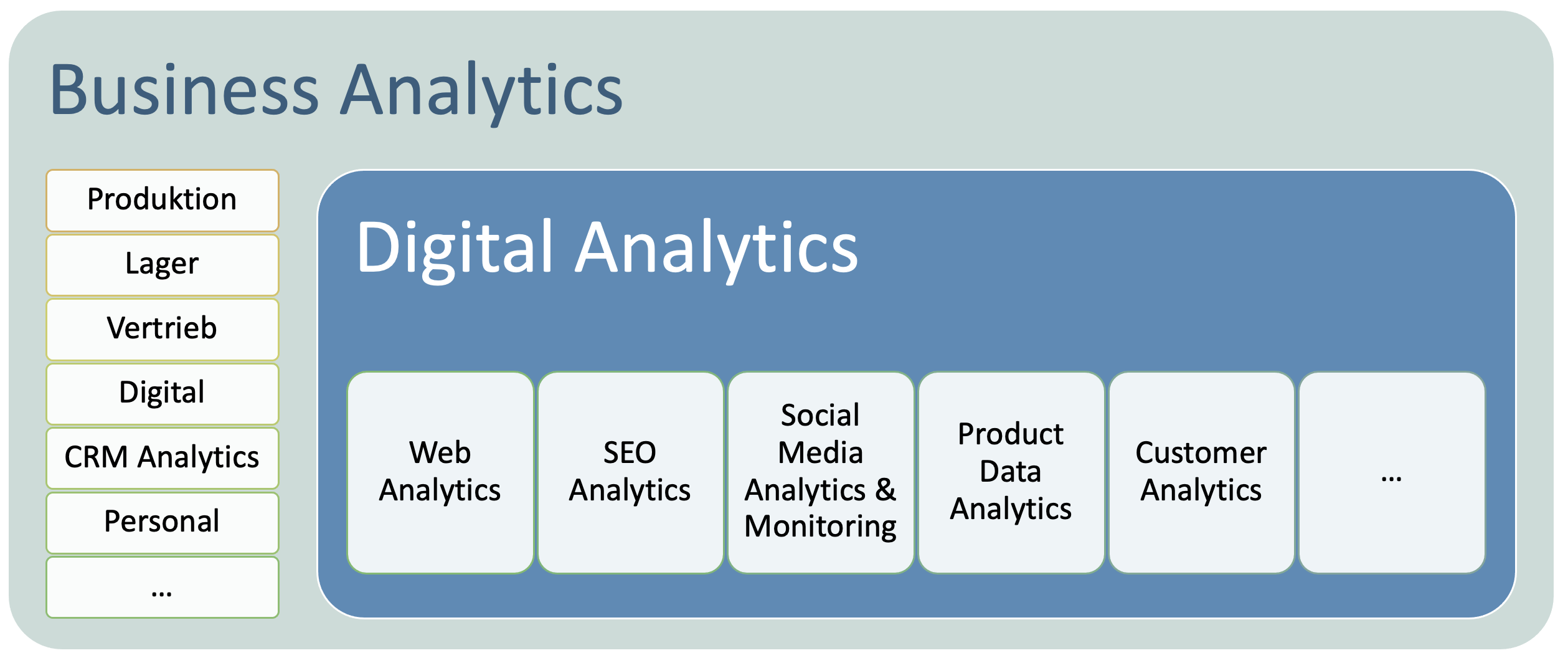

Digital Analytics sollte integrierter Teil der Business Analytics sein. Dies ist meist noch nicht wirklich so und das ist mehr als nur schade. Es ist fatal. Beide Welten sollten sich aufeinander zubewegen und gemeinsam an Optimierungsstrategien arbeiten. weiterlesen…

Schon seit einigen Jahren ist es unsinnig mit Visitor-Zahlen zu arbeiten, auch wenn Chefs und Kunden darum betteln. Warum? Valide messbar sind diese einfach nicht mehr und war diese, wenn man es genau nimmt, nie. Zu unsicher ist der Cookie, der trotz ITP und ETP zur Identifikation der Nutzer genutzt wird. Versucht man mit verschiedenen Methoden doch noch nahe an die tatsächliche Zahl zu kommen und auch andere Zusammenhänge sauberer abzubilden, so ist dies alles mehr oder weniger Bruchstückhaft und funktioniert nicht immer und unter allen Bedingungen. weiterlesen…

A/B Testing gehört einfach zum Kerngeschäft des Online-Marketing. Die Rolle des Testing als Teil der Digital Analytics ist in vielen Unternehmen mit ausgeprägtem Online-Geschäft fest implementiert. Es geht nicht mehr um die Frage, ob man testet oder darum, wie Tests funktionieren. Sicher – auch in diesem Zusammenhang gibt es beträchtliches Optimierungspotenzial. Hauptthema des Abends vergangene Woche war jedoch die Frage, wie es möglich ist, die relevanten A/B-Tests zu identifizieren und diese zu maximieren. Vorgetragen hierzu haben Bastian Schäfer (Senior Referent Website-Testing & Conversion-Optimierung bei der DB Vertrieb GmbH) sowie Viktoria Zenker und Hauke Floer aus der UX der Galeria Kaufhof weiterlesen…

In meinem letzten Beitrag zu SEO-Trends habe ich über Content-Marketing geschrieben. Nun wird es die Google Search Console. Ein wenig verwundert hat es mich schon, dass auf allen von mir besuchten Veranstaltungen die Search Console ausführlich thematisiert wurde. Dabei arbeite ich schon recht lange damit – bereits als sie Webmaster-Tools hieß und einen geringeren Funktionsumfang hatte. Sie ist ein ausgesprochen wichtiges Werkzeug. SEO-Research-Werkzeuge beziehen darüber Daten. Wenn Sie die Search Console noch nicht verwendet haben, sollten Sie sich dringend damit beschäftigen. Die Grundfunktionalitäten der Google Search Console Mit der Google Search Console kann man die Präsenz der eigenen Website in den weiterlesen…

In der empirischen Sozialforschung wird schon lange mit Gütekriterien gearbeitet. Das ist im Marketing genauso. Es gibt Gütekriterien wie diese: Validität, Reliabilität und Objektivität. Es soll korrekt gemessen werden, die Messung soll replizierbar sein und unabhängig von subjektiven Einflüssen. Oft werden noch weitere Kriterien genannt: Relevanz, Vollständigkeit, Aktualität sowie Sicherheit der Daten. Mit diesen Gütekriterien könnte man zweifellos auch solche für die Digital Analytics spezifizieren. Leider gibt es für die Digital Analytics eine anscheinend recht knifflige Herausforderung. Diese besteht einerseits häufig in der Unternehmensstruktur und in der jeweiligen Qualifikation der beteiligten Akteure. Digital Analytics oder Web Analytics wird noch immer weiterlesen…

Ich habe dieses Jahr Kundenveranstaltungen bei OnPage & Searchmetrics besucht und war auf der SMX in München. Zudem kommen einem ja noch einige andere Infos vor die Nase. Hier also einfach mal eine mehr oder weniger kritische Zusammenfassung von SEO-Trends bzw. SEM-Trends, die für mich auffällig waren. Es werden insgesamt wahrscheinlich drei Beiträge in den nächsten Wochen. Etwas zur Search-Console und zu Schema etc. werden folgen. Content Marketing, der Hyper SEO-Trend Eigentlich sollte man ja immer vorsichtig sein, wenn Supertrends kolportiert werden. In diesem Fall geht es um Content-Marketing. Oh – erwischt! Das mache ich hier mit meinem Blog auch. weiterlesen…

Pinterest-Analytics Tools hab ich schon einige beschrieben. Die Tailwind App ist mittlerweile ziemlich wichtig geworden. Sie hat 9.000 Kunden. Das ist nicht zu unrecht so. Mir gefällt das Werkzeug ausgesprochen gut. Es ist für alle alle Unternehmensgrößen einsetzbar und eine richtig gute Hilfe wenn man den eigenen Erfolg auf Pinterest monitoren und Potenziale zu Optimierung finden möchte. Ich kann den Test des Werkzeugs nur empfehlen. Immerhin hat das Unternehmen jetzt 15 Mitarbeiter. Das garantiert aus meiner Sicht den stabilen Bestand des Werkzeugs. Das Tailwind App Dashboard Der gute Eindruck beginnt schon mit dem Dashboard. Es ist aufgebaut wie das bei einem weiterlesen…

Ist das nicht nett was der Jeff Sauer da gebaut hat. Ich mag die Infografik gerne und bedanke mich höftlichst bei Jeff! Courtesy of: Depth of Knowledge by Jeffalytics

Am 11. Februar fand in Hamburg zum 4. Mal die d3con statt. Das ist so etwas wie das Klassentreffen der RTB-Branche – also rund um Real Time Bidding. Ich fand die Veranstaltung ziemlich gut und werde mit größter Sicherheit im kommenden Jahr wieder hingehen. Man erfährt so einiges wichtiges zur Raketentechnologie der Online-Werbung. Es geht um Retargeting und um die Direktansprache von Zielgruppen – also Zielgruppen-Targeting mit möglichst geringen Streuverlusten. Klassentreffen? Ein Klassentreffen an sich ist ja eine geschlossene Veranstaltung mit vielen Interna. Das ist gleichzeitig die Schattenseite eines Klassentreffens, wenn die Klasse wachsen möchte. Es gab viel Buzzword-Sprech von weiterlesen…