Irgendwas mit Daten

KI, Marken, Analytics, Mediaplanung, DAM, PIM etc.

Ich mache etwas mit Daten

KI, Marken, Analytics, Mediaplanung, DAM, PIM etc.

Das Konzept der Customer Journey – die „Reise des Kunden“ – ist eine gedankliche Abstraktion, die beschreibt, wie ein Kunde in seinem Kontakt mit einer Marke unterschiedliche Stationen durchläuft: angefangen bei den ersten Berührungspunkten über die Kaufentscheidung bis hin zur langfristigen Kundenbeziehung. weiterlesen…

Was Social Media ist, brauche ich an dieser Stelle nicht zu erläutern. Facebook, Instagram, TikTok, YouTube nehmen einen großen Raum in unserem Leben ein – mal mehr und mal weniger. LinkedIn zielt eher auf den professionellen Bereich ab – dafür werden auch Produkte benötigt. Vor mehr als 10 Jahren als ich mein Buch Social Media – Analytics und Monitoring geschrieben habe, stand dieser Teilbereich des Online Marketing noch in den Kinderschuhen. Es wurde viel versucht, ausprobiert. Das ist bei neuen Medien immer so – die Funktionsweisen für das Marketing müssen erkundet werden. Gerade die Möglichkeit zum direkten Feedback stellte viele weiterlesen…

Der Net Promoter Score (NPS) hat sich als ein Instrument in der Marktforschung etabliert, um die Loyalität und Zufriedenheit von Kunden zu messen. Durch seine einfache Methodik – eine Zahl in einem Dashboard – kann er Unternehmen, Einblicke in die Wahrnehmung ihrer Marke gewähren. Allerdings ist gerade durch die Vermeidliche Einfachheit Vorsicht geboten, wenn auf seiner Grundlage strategische Entscheidungen getroffenen werden. weiterlesen…

Kennen Sie das Riepl’sche Gesetz? Nein? Es besagt, dass „alte“ Medien nie vollständig durch „neue“ Medien verdrängt werden. Mittlerweile – die Kernaussage ist mehr als 100 Jahre alt – könnte man den Begriff der Verdrängung auch durch Transformation ergänzen. Ein Beispiel: Die gedruckte Zeitung wird nie vollständig auf Ausgabemedien wie Mobiltelefone oder Tablets transformiert. Um es deutlicher zu sagen: Erst wenn ein vollständiges funktionales Äquivalent vorhanden ist, wird dies passieren. Aber darum geht es mir in diesem Beitrag nicht im Kern. Der Kampf der klassischen Medien Derzeit kämpfen periodische Druckmedien, Hörfunk und Fernsehen gegen ihren Bedeutungsverlust im Werbemarkt. Klar ist, weiterlesen…

Suchmaschinenoptimierung ist fast so alt wie das kommerzielle Internet – vor mehr als 25 Jahren habe ich zum ersten Mal darüber geschrieben – damals in der Internet Professionell. Das Grundprinzip ist gleichgeblieben: Ein Nutzer gibt bei einer Suchmaschine einen Suchstring ein, schickt diesen ab und bekommt als Resultat eine Ergebnisliste. Im Gegenzug gibt es Betreiber von Websites, die in der Ergebnisliste oben stehen möchten – die Pole Position erreichen. Eine Suchmaschine entscheidet anhand verschiedener Kriterien, welche Seite diesen wertvollen Platz bekommt. Kriterien dafür waren anfangs die Inhalte der Seiten. Mit Google kamen externe Kriterien – unter anderem Links auf die weiterlesen…

Ein neuer Meilenstein: Der Open AI App Store An der Schwelle zum neuen Jahr plante ich, über die aktuelle Marktentwicklung im Bereich der Künstlichen Intelligenz zu schreiben, doch Zeitmangel hinderte mich daran. Jetzt hat sich die Situation dramatisch gewandelt mit der Einführung des Open AI App Stores. Viele haben diese Entwicklung übersehen, obwohl sie schon länger als Teil des Bezahlaccounts von Chat GPT existiert. Der Store beinhaltete bisher ausschließlich von Open AI entwickelte Apps, die auf dem Datenmodell von Chat GPT und DALL-E basieren und kostenlos nutzbar waren. Creative Writing Coach: Ein persönlicher Favorit Ein Highlight für mich ist der weiterlesen…

Eigentlich scheue ich mich davor, einen Beitrag zur aktuelle KI-Diskussion zu schreiben. Allerdings reagieren viele Schreiber, die aktuell Google & Microsoft überstürztes Verhalten vorwerfen, nicht viel anders in ihren eigenen Texten. Die eigene Situation wird an-analysiert – nicht bis zum Ende. Beschäftigt sich ein Mensch mit SEO, überlegt dieser zunächst, was er (oder sie) mit dem Tool machen kann – oder ob es alternativ den Job kostet. Hilfreich wäre es, zunächst nach Analogien zu suchen. Davon gibt es in der Entwicklung der Computertechnik der vergangenen 50 Jahre recht viele – sogar die bald 30 Jahre Entwicklung des kommerziellen Internets lassen weiterlesen…

Das Nutzerzentrische Bild, das Google uns mit seinen Analytics-Lösungen präsentiert, ist eben nur die eine Seite der Münze. Die andere Seite sind Produkte und Marken. weiterlesen…

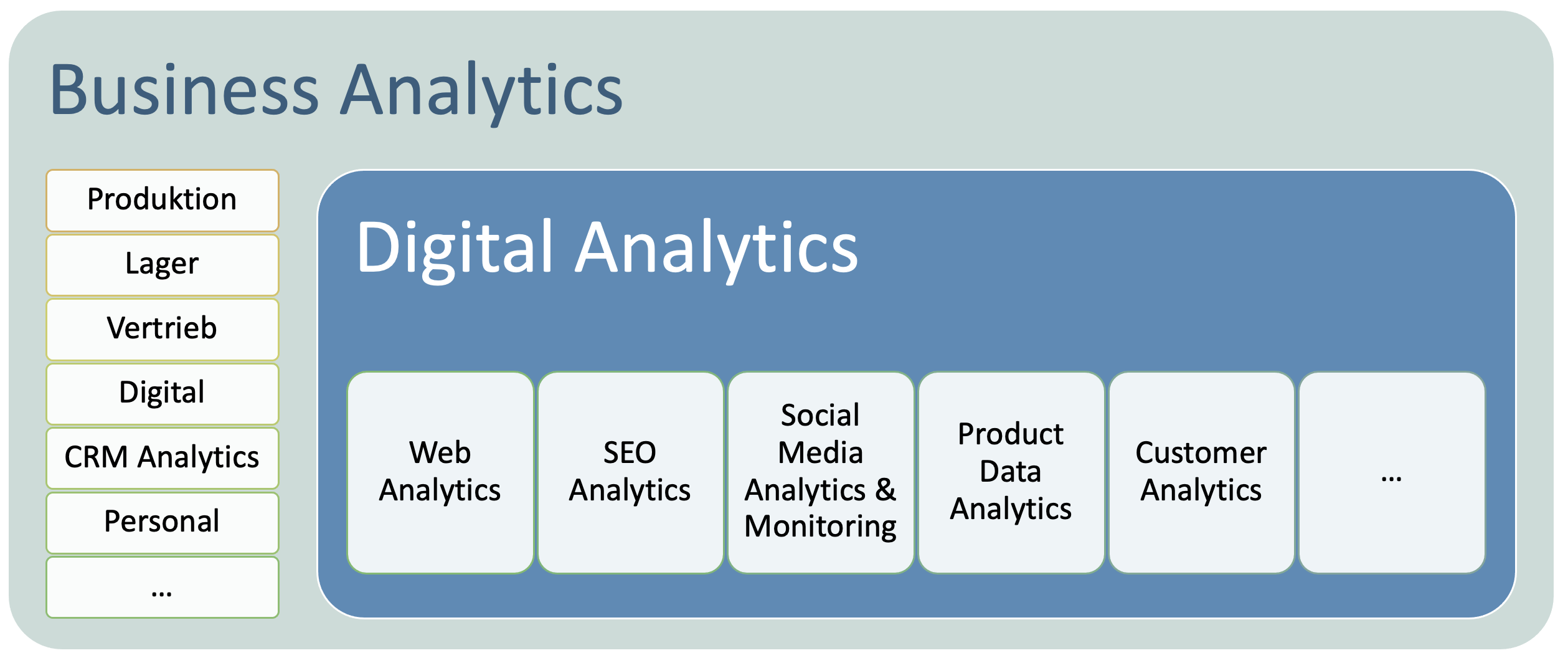

Digital Analytics sollte integrierter Teil der Business Analytics sein. Dies ist meist noch nicht wirklich so und das ist mehr als nur schade. Es ist fatal. Beide Welten sollten sich aufeinander zubewegen und gemeinsam an Optimierungsstrategien arbeiten. weiterlesen…

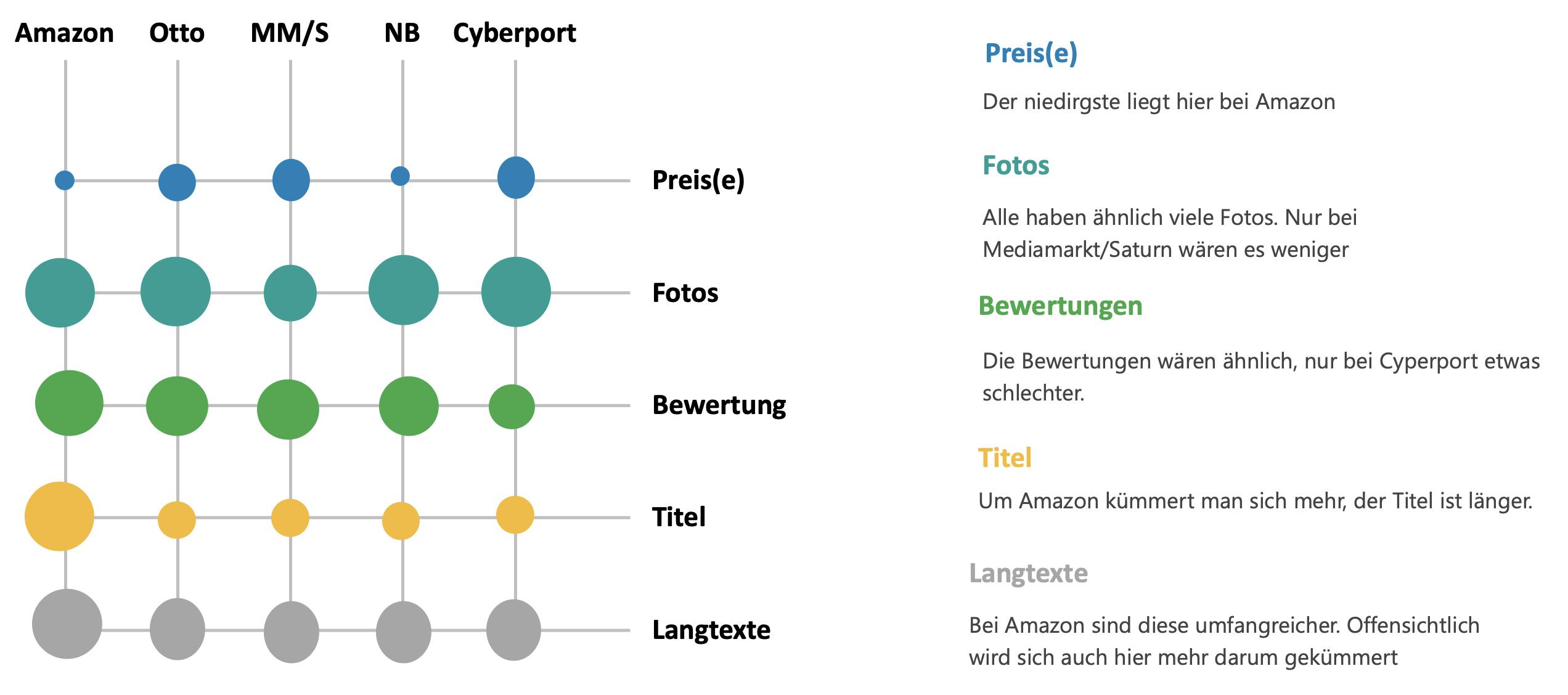

Für die Erfolgreiche Arbeit auf Online-Marktplätzen und mit Online-Händlern werden tiefgehende Informationen zu Preisen und Darstellung der Produkten auf den Plattformen benötigt – nicht nur zu Amazon. Hier erkläre ich, wie diese Daten per Product Data Crawling generierbar sind. weiterlesen…