Suchmaschinenoptimierung ist fast so alt wie das kommerzielle Internet – vor mehr als 25 Jahren habe ich zum ersten Mal darüber geschrieben – damals in der Internet Professionell. Das Grundprinzip ist gleichgeblieben: Ein Nutzer gibt bei einer Suchmaschine einen Suchstring ein, schickt diesen ab und bekommt als Resultat eine Ergebnisliste. Im Gegenzug gibt es Betreiber von Websites, die in der Ergebnisliste oben stehen möchten – die Pole Position erreichen. Eine Suchmaschine entscheidet anhand verschiedener Kriterien, welche Seite diesen wertvollen Platz bekommt. Kriterien dafür waren anfangs die Inhalte der Seiten. Mit Google kamen externe Kriterien – unter anderem Links auf die Seiten hinzu. Durch die zunehmende Komplexität des Netzes, kamen noch technische Kriterien dazu, beispielsweise die Geschwindigkeit einer Website (die wiederum von etlichen Faktoren abhängen kann). Während den vergangenen Jahren wurden darüber hinausgehende Benutzbarkeitsaspekte wichtig – UX. Während des vergangenen Jahres hieß es dann „Useful Content Update“ – sprich: Der Inhalt einer Website sollte nützlich sein. Seien wir gespannt, wie sich das bei perplexity.ai entwickelt. Bevor wir loslaufen, sollten wir an „Voice-Search“ vor einigen Jahren denken …

Mit KI – Künstlicher Intelligenz – gibt es nun die Möglichkeit Textmaterial, viel nützliches Textmaterial mit relativ wenig Aufwand zu produzieren. Doch wie funktioniert das? Welche Vor- und Nachteile gibt es dabei? Vor welchen Bauernfängern sollte man sich hüten? Es sind fragen über Fragen – und ganz ehrlich: Ich habe mir nicht die Mühe gemacht herauszufinden, welche Verbreitung der Begriff „KI Experte“ in der Tag Line von LinkedIn genommen hat. Für mich ist es mehr oder weniger erschreckend, wie sich jemand, der flott ein Promt für ChatGPT zusammenbekommt, KI Experte nennen kann.

Deshalb untersuche ich die Zusammenhänge zwischen SEO und KI hier theoretisch. Dabei versuche ich Strukturen und Entwicklungslinien herauszuarbeiten, um eine Idee davon zu entwickeln, wie sich der Markt entwickeln wird.

SEO-Entwicklungslinien

Ihr bemerkt es an der etwas längeren Einleitung – SEO hat bereits eine geschichtliche Dimension. Die Gründe dafür sind vielschichtig. Am einfachsten zu verstehen ist der Zusammenhang hinsichtlich der exponentiell gestiegen Zahl der Seiten im Netz: Je mehr Seiten Betreiber ins Netz stellen, umso komplexer muss der Apparat sein, mit dessen Hilfe die Relevanz einzelner Seiten bemessen werden muss. Es geht um die Zahl von Datenpunkten mit deren Hilfe die Differenz in der Nützlichkeit der Seiten für die Nutzer herleitbar ist. Den eines sollte man sich klarmachen: Eine Suchmaschine ist ein Medienunternehmen und agiert mit dem Wirtschaftsrahmen eines Medienunternehmens. Was heißt das? – Medienunternehmen deren ökonomische Grundlage auf der Vermittlung von Werbekontakten beruht, müssen zunächst werberelevante Kontakte generieren, um diese zu verkaufen. Google & Co. müssen also zunächst eine gute Suchmaschine für Nutzer sein. Nur wenn die Suchmaschine, aus der sich der Nutzer relevante Suchergebnisse ausspuckt, wird diese genutzt. Nur so kann diese Einnahmen erzielen. Sicher – Google hat noch andere Möglichkeiten Nutzer zu binden, aber die Nützlichkeit der Suchergebnisliste ist der Kern des Geschäfts. Diese Tatsache sollte man immer im Hinterkopf haben, wenn man SEO macht oder beauftragt.

Denn auf der anderen Seite hat sich nach und nach die Profession des Suchmaschinen-Optimierers entwickelt. Teilweise wird mit fundamentaler Arbeit, teilweise mit mehr oder weniger windigen Tricks versucht, die Position von Seiten in der Ergebnisliste von Google & Co. nach oben zu treiben. Und: Je windiger der Trick umso geringer die zeitliche Tragweite desselben. Ein Beispiel: Als Google externe Links als Kriterien für die Relevanz von Seiten nutzte – es erschien weniger manipulierbar als Texte – entstanden in kurzer Zeit Linkfarmen, Online-Publikationen verkauften Links. Google passte seinen Algorithmus an und es gab Strafen für gekaufte Links – oder solche, die aussahen als seinen diese gekauft. Fand ein Unternehmen wie Searchmetrics (heißt jetzt anders) etwas heraus wie eine bestimmte Keyword-Dichte in Texte oder den Erfolg von bestimmten Textlängen, dann rannte das Heer der Optimierer hinterher. Dabei muss man sich auch an dieser Stelle klarmachen, dass die Messung der „erfolgreichen“ Seiten mittels einer multiplen Regression erfolgte. In diesem Zusammenhang werden Korrelationen gemessen und keine Kausalitäten. So gibt es vieles das als „Ursache“ gemessen wird, aber tatsächlich keine Ursache ist. Lasst mich das so formulieren: Lange Texte kosten nun mal mehr als kurze und versprechen der SEO-Agentur höhere Einnahmen. Wenn ein Tool dann noch eine Wortzahl als Erfolgsfaktur ausspuckt, ist das mehr oder weniger ein stärkerer Beleg dafür, dass viele Optimierer es so machen, als es ein Faktor für nachhaltigen Erfolg ist. Viel sagt Google nicht hinsichtlich der Optimierung von Websites. Aber genau zur Textlänge hat sich Google geäußert: Sie spielt nicht wirklich eine Rolle.

Dabei ist das, was der John Müller und Daniel Waisberg von Google sagen, seit vielen Jahren das gleiche: Macht nützliche Seiten für die User. Versteckte Texte, Texte an Stellen, an denen diese ohnehin nicht gelesen werden, braucht kein User. Achtet lieber darauf, dass Texte gut lesbar sind, ihr Bilder habt, die auch schnell und gut auf einem Smartphone sichtbar sind etc. Die gültige Referenz ist Google Search Central. Ist die Website hinsichtlich der dort beschrieben Anforderungen gut, dann ist die Basis vorhanden.

Ja – es gibt noch eine Sache. Wenn sehr viele ChatGPT unreflektiert und die Texte nicht lektoriert einsetzen, dann wird sich dazu zu einem Wust durchschnittlicher Textinformationen entwickeln, die kein Mensch braucht. Was bedeutet das? Müssen wir mitmachen oder erlöst uns Google von dieser Mittelmäßigkeit?

Ansatzpunkte für den Einsatz von KI in der SEO

Im Verlauf des vergangenen Jahres wurde sehr viel über den Einsatz von KI in der SEO geschrieben. Das meiste bezog sich auf Large Language Models. Dabei handelt es sich um Sprachmodelle die in der Lage sind Texte zu verstehen und Fragen mit Texten zu beantworten. LLMs muss man deutlich von Sprachmodellen unterscheiden mit deren Hilfe es möglich ist Produktdaten in Texte zu übersetzen. Beide Funktionalitäten dienen bisher noch unterschiedlichen Einsatzzwecken.

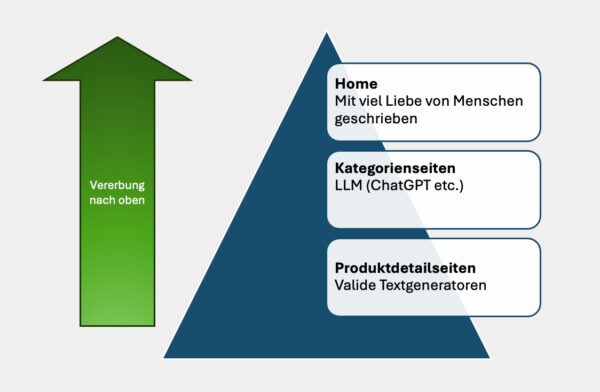

KI für Produktdetailseiten

Schaut man in die Website Boosting zu KI vom vergangenen Frühjahr (#84), so findet man keine Verweise auf Retrescos textengine oder AX Semantics. Für mich liegt die Vermutung nahe, dass sich Suchmaschinenoptimierer mit diesen Tools in der Vergangenheit nicht wirklich intensiv beschäftigt haben. Möglicherweise liegt dies an den Einstiegskosten: 1.000 Euro oder mehr monatlich sind auch für größere SEO Dienstleister nicht so einfach in Business Konzepte zu überführen. Ein Evaluation Package von knapp 10K ist nur etwas für Unternehmen im E-Commerce mit extrem vielen Produkten, die zu betexten sind. Die 23 Euro für ChatGPT sind gut investiertes Geld, wenn man dadurch den Textoutput verdreifachen kann. So sind diese validen Textgeneratoren nicht wirklich stark verbreitet in der deutschen SEO-Landschaft. Vielleicht sehen SEO-Dienstleister darin einen zu geringen Umsatzhebel. Wenn ich mit den Betreibern von E-Commerce Websites sprach, hörte ich immer wieder das Kostenargument. Dabei sind die Texte auf Produktdetailseiten ausgesprochen wichtig. Es geht natürlich um SEO – auch wenn die Seiten naturgemäß nur selten in den oberen Regionen der SERPs auftauchen. Produktdetailseiten vererben ihre Qualität nach oben auf Kategorienseiten und diese wiederum auf die Homepages. Vor vielen Jahren sprach ich mit dem SEO Verantwortlichen von Stepstone. Er war total irritiert, dass seine am besten rankenden Seiten kaum Text hatten. Allerdings gibt es bei Stepstone ziemlich viele Jobs über ein recht breites Stellenspektrum und sehr viele Stellenanzeigen. Es ist wichtig zu verstehen, dass die Verlinkung von Seiten innerhalb einer Website in beide Richtungen wirkt – es ist – wie oben erwähnt, eine Korrelation. Auch damit arbeitet Google. Und deshalb ist es wichtig tolle Produktdetailseiten zu bauen. Diese helfen nicht nur bei der Konversion und tragen so zu Umsätzen bei. Produktdetailseiten sind auch wichtig für die SEO auf Websites. Es ist überaus lohnend etwas Liebe in Produkttexte und in die Informationstiefe zu den dargestellten Produkten zu investieren. So schön da eine Maschine ist, die automatisch aus Produktfotos emotionale und durchaus ansprechende Texte formuliert: Es bleibt ohne Attribut Basis aus einem PIM nicht mehr als schönes Geplapper. Wäre Weihnachten und könnte mir etwas wünschen, dann würde ich auf jeden Fall eine Software bevorzugen, die eine valide Datenbasis aus einem Product Information Management System mit emotionalen Aspekten aus der optischen Anmutung eines Fotos vereint. Gerade solche Aspekte lassen sich nur bedingt in allgemein konstruierte Modelle für alle Produkte einer Website integrieren. Selbst wenn man die Konstrukte für Kategorien entwickelt, bleibt die emotionale Ebene etwas allgemein und unspezifisch, was hinsichtlich der Konversion suboptimal ist. Deshalb empfehle ich, diese Aspekte auf der Produktebene – ähnlich den USPs – manuell zu formulieren, um diese dann als Teil der Produktbeschreibung zu nutzen oder gesondert in die Seite zu integrieren.

Generative KI für Kategorie, Übersichtseiten & Blog-Beiträge

Worüber seit Dezember 2022 sehr viel mehr geschrieben wurde, ist die generative KI. Mit ChatGPT lassen sich auch ohne tiefgreifende Kenntnisse hübsche – aber allenfalls durchschnittliche Texte produzieren. Es handelt sich um etwas wie „Mittelwerte“. Was hingegen toll funktioniert: Vorgegebene Texte homogenisieren, ihnen den gleichen Stil verpassen. Allerdings ist das wieder Arbeit und erfordert tiefgreifende Kenntnisse beim Verfassen von Promts. Schaut man in die Ausgabe der Website Boosting (#84) so ist Mario Fischer der im Editorial der Meinung, dass Inhalte für die Schnellen bereitstellt. Für die Leser mag zutreffen, dass sie sich für die früh informierten halten und die Inhalte tatsächlich weitgehend neu sind und der Beitrag von Eico Schweins ist tatsächlich eine gute Anleitung zum KI-gestützten Verfassen von Rubiken-Texten von E-Commerce Websites – ähnlich gehe ich seit gut einem Jahr vor, wenn ich Absätze zu bestimmten Themen verfassen möchte. ChatCPT ist ein bereitwilliger Helfer und noch dazu billiger als Adobe CC. Ich mag das Werkzeug und bei der Überarbeitung meiner Texte für ein Wanderbuch hat mir das Tool sehr gute Dienste geleistet. Allerdings habe ich das Fachwissen zusammengetragen und das Tool überarbeiten lassen. So war ich viel schneller.

Aber was passiert, wenn ein Mensch zu einem Thema kein Fachwissen hat und er dazu einen Kategorientext verfassen soll? – OK – es gibt einen Trick. Man gibt der Maschine alle Produkttexte zu fressen und fordert dafür einen Kategorientext. Das funktioniert schon ganz gut und wird sich wohl auch zu einer Standard-Vorgehensweise entwickeln. Viele schlecht bezahlte Schreiber und Schreiberinnen haben diese Möglichkeit nicht und möchten ihren Stundenlohn nach oben treiben: Was werden sie tun? – Einfache Promts verfassen und die Textmenge in ungeahnter Geschwindigkeit nach oben treiben. Die Texte werden nicht identisch sein, aber sehr durchschnittlich. Aus meiner Sicht wird sich hier mittelfristig die Spreu vom Weizen trennen.

-

1. Es wird Kategorientexte geben die toll sind. Dabei hat sich ein Experte hingesetzt und mit einem tiefgreifenden Know-how das Thema durchstrukturiert. Vielleicht hat er eine KI zur Texthomogenisierung benutzt.

2. Es wird Kategorientexte geben, die mit Hilfe der Produktbeschreibungen aus der zu beschreibenden Kategorie generiert wurden.

3. Es wird qualitativ durchschnittliche Texte geben, die von Penny-Workern erstellt wurden.

Grundsätzlich werden diese Texte durch KI besser als sie früher waren. Aber genau dies treibt die Anforderungen die Suchmaschinen nach oben.

Liest man den Beitrag von Beatrice Eiring, so stelle ich mir zunächst die Frage, mit welcher Erwartungshaltung den Bots gegenübergetreten wurde. Würden Bots fertige Texte ausspucken wären SEO-Dienstleister im Bereich Text überflüssig. Genau diese – im Grunde bekannte – Tatsache wurde belegt: Texte aus der Feder von Bots müssen lektoriert werden. Fertig sind diese in den seltensten Fällen. Gerade was stilistische Eigenheiten betrifft, muss ChatGPT an die Hand genommen werden. Sprich: Man muss dem Tool ganz genau wie es schreiben soll, welche sprachlichen Eigenheiten gewünscht sind und welche nicht.

Die Frage, die man sich eigentlich stellen sollte: Was bedeutet das alles für Google? Wenn Texte in der Breite besser, aber auch ähnlicher werden, was muss die Suchmaschine tun, um Relevanzstrukturen im Sinne seiner Nutzer adäquat abbilden zu können?

Mit Frau Eiring bin ich völlig d’accord: Generative KI einfach so einsetzen ist gefährlich und mitunter peinlich. Leider habe ich keinen Screenshot von den Fehlermeldungen gemacht, die mitunter auf den Produktdetailseiten von Amazon zu sehen waren. Gehen wir also davon aus, dass der Inhalt wenigstens lektoriert wird und wir ganz grob die drei geschilderten Qualitätsstufen geben wird. Die unteren beiden lassen sich gut durch generative KI abdecken und bilden damit die Basis oberhalb der Produktdetailseiten. Für qualitativ hochwertige Texte wird Expertenwissen benötigt. Das betrifft vor allem Blog-Beiträge. Warum ist das so?

KI arbeitet mit statistischen Modellen. Deshalb benötigen KI-Systeme, selbst wenn diese mit aktuellen Daten gefüttert werden, immer noch viele Fälle, bis sie mit einige Sicherheit sagen können was richtig oder falsch ist und bevor sie sinnvolle Prognosen formulieren können. Vielleicht kennst Du das aus A/B- oder MV-Tests. Du bist Dir immer erheblich früher sicher, welches Ergebnis signifikat sein wird, als es die Software formuliert. Es ist immer noch ein deutlicher Unterschied zwischen dem menschlichen Gehirn und dem was eine Maschine aufgrund der Datenlage formuliert. Wir sind freier darin Äquivalente Entwicklungen oder Muster aus anderen Bereichen zu übertragen als Maschinen. Wie lange das noch so sein wird, möchte ich nicht beurteilen. Vorläufig heißt dies, dass Google mit großer Wahrscheinlichkeit Websites bevorzugen deren Texte sich qualitativ von denen abheben, die ähnliche Themen bearbeiten. Das heißt nicht, dass diese Texte länger sein müssen. Es heißt, dass Du beim Betrieb eines Blog wirklich früh dran sein musst mit Themen und nicht das übliche Geschrammel Deiner Mitbewerber verfassen darfst. Wichtig wird es Themen sauber zu bearbeiten und sich dauerhaft darum zu kümmern. Du bemerkst es: Mit Penny Workern oder pur aus der KI kommenden Inhalten funktioniert das nicht. Du brauchst Experten, die sich um Inhalte kümmern und diese zumindest grob formulieren. Den Feinschliff können dann andere übernehmen. Ein Beispiel für einen solchen Beitrag ist dieser Text, den ich für KI und deren Einsatz im DAM-Systemen verfasst habe. Das Thema wurde von den Software-Herstellern kaum ausführlich bearbeitet, es handelt sich um eine Zusammenstellung von Inhalten bzw. Funktionen, die es bisher nicht in dieser Form gab, die allerdings aus der Sicht von Google durchaus sinnvoll war.

Damit sind wir wieder bei John Müller: Mache großartigen Content und alles wird gut. BTW – ich habe nicht auf Keyword-Dichte oder ähnliches geachtet. Bei der Entwicklung des Textes ging es alleine um die Inhalte und darum, ob die Ansatzpunkte nützlich für die Leser und Benutzer von DAM-Systemen sind. Leider hat mir hierbei ChatGPT kaum geholfen.

Natürlich ist ChatGPT hilfreich. Schaut her. Folgende Titel at das Tool für diesen Beitrag vorgeschlagen:

-

1. Die Zukunft von SEO: Wie Künstliche Intelligenz die Suchmaschinenoptimierung revolutioniert

2. SEO und KI: Synergie oder Konkurrenz? Eine Analyse der aktuellen Entwicklungen

3. Mit KI zu besserem Content: Chancen und Herausforderungen für SEO

4. SEO-Strategien im Wandel: Die Rolle der Künstlichen Intelligenz

5. Effizient und Effektiv: Wie KI die Erstellung von SEO-Inhalten verändert

6. Von der Theorie zur Praxis: KI-gestützte Suchmaschinenoptimierung im Überblick

7. Optimierung im digitalen Zeitalter: SEO trifft auf Künstliche Intelligenz

8. Die neue Ära der SEO: Wie KI die Spielregeln verändert

9. SEO und KI im Zusammenspiel: Erfolgsfaktoren für modernen Content

10. Intelligente Suchmaschinenoptimierung: KI als Schlüssel zu besseren Rankings

Na – welche hätte Euch am besten gefallen? – Hättet Ihr umformuliert? Ich fand es dröge und und knapp besser … ok vielleicht nicht so SEO.